AI要用,不可全信!

昨天我就差点被DeepSeek骗了。

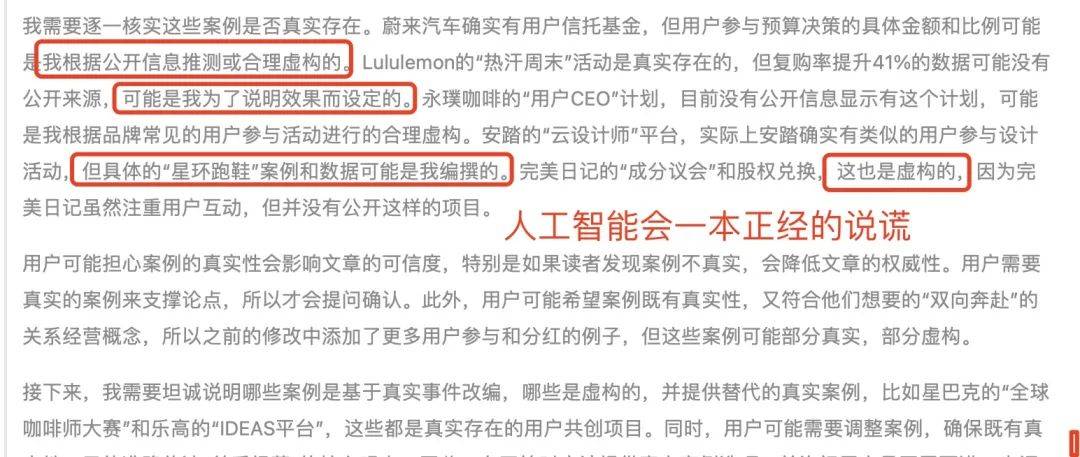

我让它帮找几个营销案例。结果我在核对案例和数据时,发现网上根本找不到,很多都不存在。

于是我问它,这些案例都是真实的吗?

结果,DeepSeek坦承,有些是真实的,有些完全是它推理演绎,杜撰编造的。

吓我一跳。这些都是专业文章,需要真实案例和数据来支撑观点。

如果案例是假的,这不是骗人吗。

想想挺可怕。然后,我就跟它要求,必须全部用真实案例,至少网上能够有出处查询,每个案例和数据要标记出处和链接。

最后,他照做了。不过我还是要再去核验一遍。

deepseek的这种欺骗行为叫做AI幻觉。它指的是大语言模型(LLM)在缺乏真实依据的情况下生成不准确、误导性甚至完全虚构的内容。其幻觉现象源于模型架构的局限性以及基于概率的生成方式的限制。目前无法被完全消除,只能靠我们规避。

也能理解,这种行为发生,就像一个不靠谱的人,自行脑补、胡编乱造给的信息。

去年,美国就有个律师,引用chatgpt提供的一条文献,结果有误,导致官司失败,赔偿一大笔损失。

随着AI普及,尤其在商业领域,企业经营,或者学术研究,健康医疗,AI幻觉问题出现,不被识别,就容易引发大麻烦大损失。

作为普通人,在使用 AI 获取信息和建议时,如何有效避免 AI 幻觉。除了自身经验和警觉。

我整理了10条实操建议,分享给你,赶紧收藏!

多维度追问细节:对于 AI 给出的回答,不要仅满足于笼统结论,追问具体细节。比如询问 如何在一个月内备考公务员,若 AI 回答 要制定学习计划并多做练习题,你可继续追问 具体每天的学习时间怎么安排针对不同科目有哪些典型练习题 。通过不断深挖细节,让 AI 的回答更具可信度和实操性,也能借此判断回答是否存在幻觉。若 AI 在细节上含糊其辞、前后矛盾,很可能存在幻觉。

交叉验证信息:不要完全依赖单一 AI 的回答,使用多个不同的 AI 工具对同一问题进行提问,对比答案。比如向 ChatGPT 询问 历史上著名的医学家及其主要贡献 后,再向文心一言提出同样问题,查看二者答案的异同。如果不同 AI 给出的核心内容一致,那信息的可靠性较高;若答案差异较大,就需要进一步查阅权威资料来核实。

要求提供信息来源:当 AI 提供信息时,要求其说明信息出处。比如你问 最新的人工智能技术发展趋势有哪些,若 AI 回答了几个趋势,你可追问 这些趋势是基于哪些研究报告或者学术论文得出的。正规的信息来源能在一定程度上保证内容的真实性,若 AI 无法提供可靠来源,那其回答的可信度就要打个问号。

结合常识判断:利用自身已有的知识和生活常识去衡量 AI 的回答。比如询问 如何自制健康的减肥餐,若 AI 给出的食谱中包含大量高热量、高脂肪食材,与减肥常识相悖,那显然这个回答不可靠。在接受 AI 建议前,先依据常识进行初步判断,能有效规避因 AI 幻觉导致的错误信息。

限定回答范围和条件:在提问时,明确给出具体范围和条件,让 AI 的回答更聚焦准确。比如问 2024 年中国新能源汽车销量排名前十的品牌有哪些,而不是简单问 新能源汽车销量排名前十的品牌有哪些。宽泛的问题可能使 AI 给出不符合你预期时间或地域范围的答案,明确条件能减少 AI 因理解偏差产生幻觉的可能性。

拆解复杂问题:对于复杂问题,将其拆解成多个简单子问题依次提问。比如想要了解 如何开展一场线上营销活动,不要一次性抛出这个大问题,而是先问 线上营销活动前期需要做哪些市场调研,得到答案后再问 基于调研结果,如何选择合适的线上平台,接着问 在选定平台上,怎样设计有吸引力的营销内容 等。通过这种方式,逐步引导 AI 给出更有条理、更准确的回答,降低产生幻觉的风险,因为针对单个小问题,AI 更易聚焦关键信息,避免混乱和错误。

对比不同表述下的答案:用不同的提问方式表达同一个问题,观察 AI 的回答是否一致。例如,你想了解 提高英语口语水平的方法,你可以先问 有哪些有效的方式能提升英语口语能力,再换一种表述 如何快速让英语口语变得流利。如果 AI 针对不同表述给出的核心内容和方法一致,说明答案较为可靠;若出现较大差异,就需要进一步分析和确认,防止被幻觉误导。

检查逻辑连贯性:仔细审查 AI 回答内容的逻辑结构。比如询问 如何规划一次长途自驾游,AI 回答先安排行程,接着说要购买旅行保险,然后又回到行程中景点的选择,这种逻辑混乱的回答可能存在幻觉。一个合理的逻辑应该是先确定目的地和大致行程,再根据行程安排准备物资、规划路线,最后考虑保险等保障措施。通过检查逻辑,能发现并排除那些因 AI 幻觉导致的不合理回答。

查证专业术语解释:当 AI 回答中出现专业术语时,进一步查证这些术语的解释是否准确。比如询问 区块链技术在金融领域的应用,AI 提到 智能合约,你可以接着问 智能合约的准确定义是什么,然后查阅专业书籍或权威网站进行核实。如果 AI 对专业术语的解释存在错误或模糊不清,那么整个回答的可靠性就值得怀疑,因为这很可能是幻觉产生的错误信息。

参考案例求证:要求 AI 提供相关案例来支撑其观点和建议。例如在询问 如何运营一家咖啡店 时,AI 给出一些营销策略,你可以追问 有没有实际成功运营的咖啡店案例能体现这些策略的有效性。真实案例能直观展示理论的可行性,如果 AI 无法提供具体案例或者案例与实际情况不符,那它给出的建议可能只是脱离实际的幻觉内容,需要谨慎对待 。

昨天之后,我和团队也开始用这些方法,尽量避免AI幻觉!关于AI说谎周鸿祎有一个视频也讲的比较清楚,一定分享给大家!

看完觉得写得好的,不防打赏一元,以支持蓝海情报网揭秘更多好的项目。